Já vimos aqui no blog a importância do Spark e do PySpark no mundo de Big Data e Engenharia de Dados (post). Hoje, vamos aprender como configurar um ambiente para trabalhar com o pyspark e utilizá-lo em sua máquina local e, posteriormente, exportá-lo para uma arquitetura mais robusta e profissional.

Para facilitar a explicação e tornar o aprendizado mais acessível, utilizaremos o ambiente Anaconda.

Instalando o Anaconda

Baixar o instalador

- Abra o navegador de sua preferência e acesse o site oficial do Anaconda: https://www.anaconda.com.

- Clique em Download ou navegue até a seção de downloads.

- Escolha o instalador adequado para o sistema operacional do seu computador:

- Windows

- macOS

- Linux

- Selecione a versão correspondente à arquitetura do seu sistema (geralmente 64 bits) e faça o download do arquivo.

Executar o instalador

- Localize o arquivo baixado na pasta de downloads.

- Clique duas vezes no instalador para executá-lo.

Instalar o Anaconda

Para Windows:

- Clique em Next na tela inicial do instalador.

- Leia e aceite o contrato de licença e clique em Next.

- Escolha um local para a instalação ou utilize o padrão sugerido.

- Marque a opção para adicionar o Anaconda ao PATH (opcional, mas recomendado).

- Clique em Install e aguarde a conclusão da instalação.

- Finalize o processo clicando em Finish.

Para macOS/Linux:

- Abra o terminal e navegue até a pasta onde o arquivo foi baixado.

- Torne o arquivo executável, se necessário, com:

chmod +x nome_do_arquivo_instalador.sh

- Execute o instalador:

./nome_do_arquivo_instalador.sh

- Siga as instruções na tela para concluir a instalação.

Verificar a instalação

- Abra o terminal (ou Prompt de Comando no Windows).

- Digite:

conda –version

- Se a instalação foi bem-sucedida, você verá a versão do Anaconda instalada.

Usando o Anaconda Navigator

Abrir o Anaconda Navigator:

-

No Windows, procure por “Anaconda Navigator” no menu Iniciar e abra-o.

-

No macOS/Linux, execute no terminal:

anaconda-navigator

Iniciar o Jupyter Notebook:

-

No Anaconda Navigator, localize o ícone do Jupyter Notebook.

-

Clique em “Launch”.

Usar o Navegador:

-

O Jupyter Notebook será aberto automaticamente no navegador padrão.

-

Selecione ou crie um diretório para armazenar seus notebooks e comece a trabalhar!

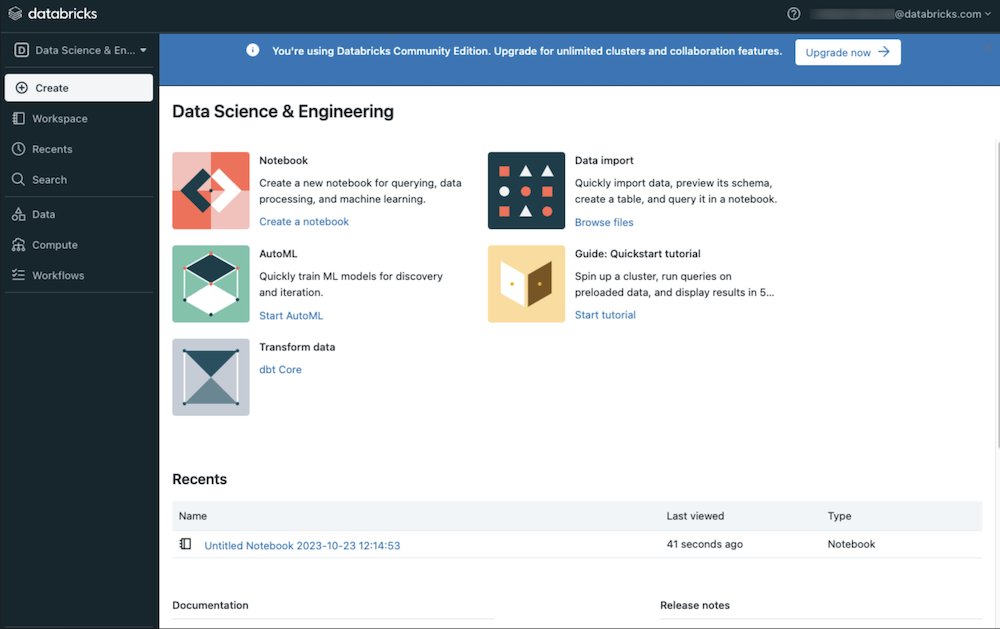

Instalando o PySpark

- No Jupyter notebook, crie um novo notebook.

- Na primeira celula do notebook digite:

![]()

- Aguarde alguns instantes até que a instalação seja concluída.

Verificando a instalação

- Após a instalação crie um nova celula e digite o seguinte código:

O código irá analisar se o PySpark foi instalado e a versão.

Após isso, o Spark está instalado em sua máquina e você pode utilizar as funções do python e pyspark para manipular dataframes.

Configurando Spark

Vamos configurar o Spark, através do pyspark, para utilizar a nossa máquina como nó master e alguns núcleos do processador nós executores.

Na célula seguinte digite:

Explicação da configuração:

- master(“local[2]”) → Define a máquina local como o nó principal (master) e utiliza dois núcleos da CPU como executores.

- config(“spark.executor.memory”, “4g”) → Cada nó executor terá 4 GB de memória.

- config(“spark.driver.memory”, “2g”) → O driver (responsável por coordenar as tarefas) terá 2 GB de memória.

Agora, o Spark está instalado e configurado! Com essa sessão, você pode processar e analisar dados utilizando o PySpark, aproveitando os recursos da sua máquina conforme as configurações definidas.

- Preparando um ambiente para trabalhar com o PySpark - janeiro 29, 2025

- O PySpark - janeiro 12, 2025

- O que é Azure? - janeiro 12, 2025