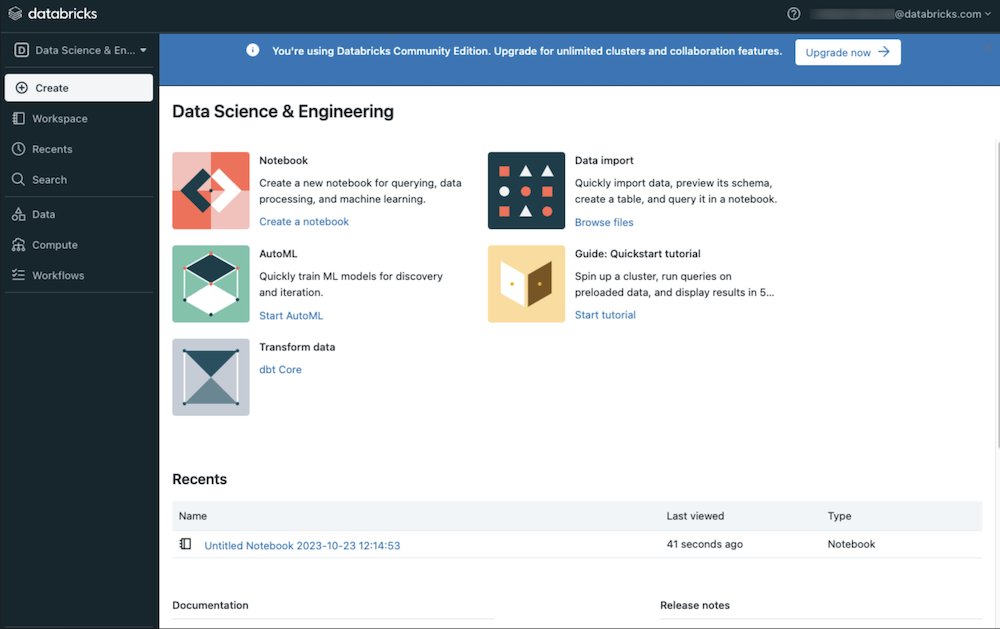

No universo dos dados, existem diversas ferramentas importantes, e uma delas é o Databricks. Atualmente, o Databricks se destaca como uma das plataformas mais relevantes em áreas como Engenharia de Dados, Análise de Dados e Machine Learning em ambientes de nuvem. Ele é uma ferramenta fundamental para engenheiros de dados, pois facilita diversas atividades, como a criação de pipelines, desenvolvimento de ETLs e a governança de dados.

Neste artigo, exploraremos o que é o Databricks, suas aplicações e como ele pode transformar o trabalho com dados.

O que é Databricks?

Para entender melhor o propósito do Databricks, vamos usar uma analogia.

Imagine um chef de cozinha altamente qualificado, especializado em preparar pratos variados e nutritivos de maneira ágil e eficiente. Embora ele seja excepcional em seu trabalho, não possui uma cozinha própria nem armazena ingredientes. Em vez disso, ele aluga cozinhas (clusters de computação em nuvem) e utiliza os utensílios disponíveis (como o Apache Spark) para transformar ingredientes (dados) em pratos excepcionais (insights).

De forma semelhante, o Databricks opera assim no mundo dos dados:

- Ele não armazena dados diretamente, mas se conecta a provedores de nuvem como Azure, AWS ou GCP para acessar e processar grandes volumes de informações.

- Ele oferece uma plataforma unificada para análise de dados, engenharia de dados, ciência de dados e aprendizado de máquina.

- Com o suporte de tecnologias modernas, como o Delta Lake e transações ACID, transforma dados brutos em valor estratégico.

Resumidamente, o Databricks é uma plataforma que potencializa diversas atividades relacionadas a dados, mas depende de estar integrada a um ecossistema de nuvem, como Azure, AWS ou GCP.

Qual problema o Databricks resolve?

Muitas empresas enfrentam desafios relacionados ao armazenamento e processamento de dados. Geralmente, elas utilizam dois tipos principais de armazenamento:

- Data Warehouses:

Focados em dados estruturados, com forte ênfase em segurança e agilidade para análises rápidas. Contudo, possuem limitações quanto ao suporte a tipos variados de dados. - Data Lakes:

Adequados para armazenar grandes volumes de dados estruturados, semiestruturados e não estruturados. Apesar disso, carecem de segurança e não oferecem boa performance para análises rápidas.

O Databricks resolve o dilema de dados estruturados e não estruturados com o conceito de Data Lakehouse, que combina o melhor de ambos os mundos. A abordagem de Data Lakehouse possibilita:

- Armazenar diversos tipos de dados em um único ambiente.

- Garantir segurança, escalabilidade e agilidade para análises.

- Oferecer transações ACID por meio do Delta Lake, tornando a análise e governança mais robustas.

Para que é utilizado o Databricks?

Com o Data Lakehouse, as empresas podem armazenar seus dados em ambientes de nuvem e, utilizando o Databricks, realizar uma ampla gama de atividades, como:

- Processamento e gestão de dados, incluindo ETLs.

- Geração de dashboards e visualizações para suporte à decisão.

- Implementação de segurança e governança de dados.

- Exploração e anotação de dados para ciência de dados.

- Treinamento, rastreamento e manutenção de modelos de Machine Learning (ML).

- Criação de soluções avançadas, como IA generativa.

Qual a origem do Databricks?

O Databricks foi fundado em 2013 por um grupo de pesquisadores da Universidade da Califórnia, Berkeley, que fazia parte do laboratório AMPLab. O objetivo da criação da plataforma, liderada por Matei Zaharia, era simplificar o trabalho com grandes volumes de dados e aprendizado de máquina.

Desde então, o Databricks tem revolucionado o ecossistema de dados ao:

- Integrar ferramentas avançadas como o Apache Spark para processamento distribuído.

- Oferecer um ambiente colaborativo em nuvem que unifica armazenamento de dados, notebooks e automação de pipelines.

- Facilitar a adoção de big data e machine learning em larga escala.

Conclusão

O Databricks é uma ferramenta essencial no ecossistema de dados modernos, oferecendo uma solução inovadora que atende às demandas de armazenamento, segurança e análise de dados de forma escalável. A integração do melhor dos Data Warehouses e Data Lakes, por meio do conceito de Data Lakehouse, torna-o uma escolha estratégica para empresas que buscam transformar dados em insights valiosos.

Com suporte a tecnologias de ponta como Apache Spark e Delta Lake, o Databricks simplifica o trabalho de engenheiros e cientistas de dados, permitindo a implementação de soluções que vão desde ETLs até inteligência artificial avançada. Integrado a provedores de nuvem como AWS, Azure e GCP, ele capacita empresas a inovar e tomar decisões orientadas por dados, tornando-se um parceiro indispensável na era da informação.

- Preparando um ambiente para trabalhar com o PySpark - janeiro 29, 2025

- O PySpark - janeiro 12, 2025

- O que é Azure? - janeiro 12, 2025